Học sâukeo 88, lý thuyết thông tin và thống kê học

2017-01-06

Năm ngoái99WIN, không có từ ngữ công nghệ nào nổi bật hơn “trí tuệ nhân tạo” cả. Và cách đây không lâu, sự kiện chiến thắng liên tiếp của tay cơ ẩn danh Master một lần nữa đã đưa chủ đề này trở thành tâm điểm chú ý trước công chúng. Tuy nhiên, với tư cách là một kỹ sư công nghệ, tôi không chỉ dừng lại ở việc quan sát cho vui. Cũng như bạn, tôi vô cùng tò mò về những cơ chế vận hành đằng sau công nghệ đầy thú vị này. Tôi thường tự hỏi, làm thế nào trí tuệ nhân tạo có thể phân tích và đưa ra quyết định trong thời gian thực? Nó thực sự là một hệ thống phức tạp được lập trình theo cách nào để có thể học hỏi và thích nghi nhanh chóng đến vậy? Những câu hỏi như vậy luôn thôi thúc tôi tìm hiểu sâu hơn về lĩnh vực này, bởi tôi tin rằng, sự phát triển của trí tuệ nhân tạo sẽ thay đổi rất nhiều khía cạnh trong cuộc sống của chúng ta trong tương lai. Đối với tôi, trí tuệ nhân tạo không chỉ là một công cụ mà còn là một đối tác tiềm năng trong nhiều ngành nghề, từ y học đến giáo dục, và thậm chí cả nghệ thuật. Nhưng đồng thời, nó cũng đặt ra nhiều câu hỏi về đạo đức và trách nhiệm khi con người ngày càng phụ thuộc vào công nghệ. Đây là điều khiến tôi suy ngẫm nhiều hơn và muốn chia sẻ với mọi người về tầm quan trọng của việc hiểu rõ công nghệ mà chúng ta đang sử dụng mỗi ngày.

Trung tâm của trí tuệ nhân tạo hiện nay chính là học sâu. Nhưng tại sao học sâu lại có thể hoạt động hiệu quả trong thế giới thực? Tại sao khi cung cấp cho nó một lượng lớn dữ liệuđánh bài online, nó có thể tự "học" được những điều mà con người gọi là kiến thức? Liệu có nền tảng toán học vững chắc hay thậm chí là triết học đằng sau nó không? Những câu hỏi này luôn khiến tôi tò mò và tìm kiếm lời giải đáp. Vì vậy, gần đây tôi đã dành nhiều thời gian để nghiên cứu về lĩnh vực này, và tôi phát hiện ra rằng học sâu không chỉ liên quan chặt chẽ đến lý thuyết thông tin mà còn gắn bó mật thiết với xác suất và thống kê. Nhiều khái niệm vốn dường như rời rạc hóa ra đều có mối tương quan chặt chẽ với nhau, tạo nên một hệ thống phức tạp nhưng hợp lý. Hơn nữa, khi đi sâu hơn vào các thuật toán học sâu, tôi nhận thấy rằng chúng không chỉ đơn thuần là công cụ để xử lý dữ liệu, mà còn phản ánh cách con người hiểu và tổ chức thế giớ Có lẽ đó là lý do vì sao học sâu có thể ứng dụng vào nhiều lĩnh vực khác nhau từ hình ảnh, âm thanh cho đến ngôn ngữ, và thậm chí mở ra cánh cửa cho trí tuệ nhân tạo trở thành một phần không thể thiếu trong cuộc sống hàng ngày của chúng ta. Tuy nhiên, câu hỏi lớn nhất vẫn còn bỏ ngỏ: liệu học sâu có thực sự hiểu được thế giới theo cách con người hiểu hay nó chỉ là một mô phỏng thuần túy của các quy luật toán học và logic? Điều này tiếp tục kích thích trí tò mò của tôi và khiến tôi muốn khám phá thêm về tiềm năng vô tận của công nghệ này.

Trong bài viết nàyđánh bài online, tôi sẽ cố gắng tổng hợp những nguyên lý và khái niệm toán học liên quan, đồng thời đi sâu vào một số chi tiết khi cần thiết. Tuy nhiên, trọng tâm vẫn là giải thích theo hướng mang tính nguyên tắc để độc giả không có nền tảng trước cũng có thể hiểu được phần lớn nội dung. Tôi hy vọng rằng, bằng cách tiếp cận này, mọi người đều có thể nắm bắt được cốt lõi của vấn đề mà không cảm thấy quá khó khăn.

Một số khái niệm phổ biến

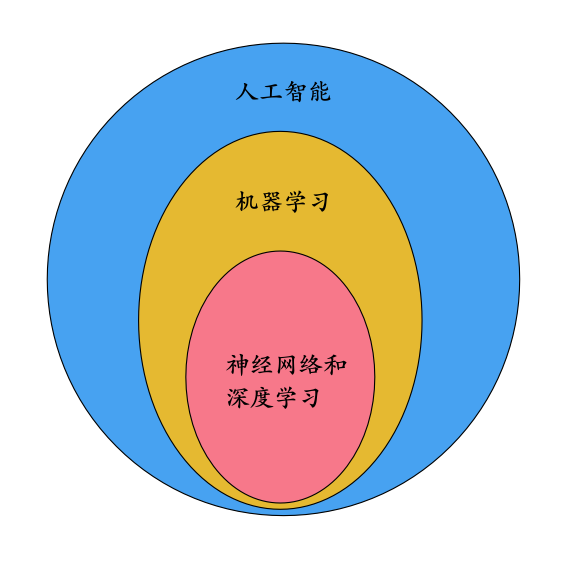

Chúng ta thường nghe nhắc đến những khái niệm phổ biến như trí tuệ nhân tạokeo 88, học máy, mạng thần kinh và học sâu trong cuộc sống hàng ngày. Để giúp việc trình bày sau này trở nên rõ ràng hơn, hãy cùng nhìn vào một biểu đồ minh họa mối quan hệ bao hàm giữa các khái niệm này: Trí tuệ nhân tạo (AI) là thuật ngữ rộng nhất, bao gồm tất cả các lĩnh vực liên quan đến việc tạo ra hệ thống có khả năng thực hiện công việc giống như con người. Trong đó, học máy (machine learning) là một phần quan trọng của AI, cho phép hệ thống cải thiện hiệu suất theo thời gian mà không cần lập trình cụ thể. Mạng thần kinh (neural network), một phần của học máy, mô phỏng cách hoạt động của não bộ để xử lý dữ liệu phức tạp. Cuối cùng, học sâu (deep learning) là một nhánh phát triển mạnh mẽ từ mạng thần kinh, sử dụng nhiều lớp kết nối để phân tích dữ liệu theo cấp độ sâu. Biểu đồ sau sẽ giúp bạn dễ dàng hình dung hơn về mối quan hệ này.

Mối quan hệ giữa hai khái niệm mạng nơ-ron và học sâu luôn là chủ đề gây tranh cãi. Có người cho rằng học sâu là một phần của mạng nơ-ronđánh bài online, và học sâu chính là mạng nơ-ron đa lớp; trong khi đó, một số khác lại tin rằng hai khái niệm này có mối liên hệ Chúng ta không cần đi sâu vào tranh luận về vấn đề này ở đây, vì có thể tạm thời hiểu theo cách đầu tiên mà không ảnh hưởng đến những gì sẽ được thảo luận tiếp theo. Tuy nhiên, để hiểu rõ hơn, hãy hình dung rằng học sâu thực sự dựa trên việc xây dựng các mô hình phức tạp từ nhiều lớp mạng nơ-ron. Những lớp này làm việc cùng nhau để xử lý dữ liệu và rút ra kết luận một cách tự động. Điều này có nghĩa là, trong một số trường hợp, chúng ta có thể xem học sâu như một dạng mở rộng của mạng nơ-ron, với trọng tâm là khả năng giải quyết các vấn đề phức tạp hơn mà không cần con người trực tiếp can thiệp quá nhiều. Dù sao đi nữa, điều quan trọng là phải hiểu rằng dù hai khái niệm này có liên quan chặt chẽ, chúng vẫn giữ những đặc điểm riêng biệt và đóng vai trò quan trọng trong lĩnh vực trí tuệ nhân tạo.

Lưu ý: Nếu bạn muốn hiểu trực quan và chi tiết hơn về mạng nơ-ron và học sâu99WIN, xin vui lòng tham khảo bài viết khác của tôi trước: Bạn có cần hiểu công nghệ học sâu và mạng thần kinh không?

Các nguyên tắc toán học được mô tả trong phần dưới đây hầu hết đều áp dụng cho hầu hết các trường hợp của học máy và học sâu.

Tại sao phải sử dụng xác suất để mô tả?

Khi còn học đại họcđánh bài online, chúng ta thường được học về lý thuyết xác suất và hiểu rằng các hiện tượng ngẫu nhiên có thể được biểu thị bằng xác suất. Tuy nhiên, trong sâu thẳm nội tâm, tôi luôn có những câu hỏi về khái niệm liên quan đến yếu tố ngẫu nhiên: Liệu hiện tượng ngẫu nhiên thực sự là bản chất của sự vật, hay chỉ là kết quả của việc chúng ta thiếu thông tin đủ để hiểu rõ hệ thống đó? Có lẽ, trong thế giới tự nhiên, nhiều hiện tượng mà chúng ta gọi là "ngẫu nhiên" thực tế lại mang một cấu trúc tiềm ẩn nào đó mà con người chưa thể khám phá ra. Có khi nào những gì chúng ta coi là ngẫu nhiên chỉ là dấu hiệu của một thứ logic phức tạp hơn mà mắt thường không thể nhận ra? Đây thực sự là một câu hỏi thú vị, khiến tôi luôn trăn trở và tìm kiếm lời giải đáp từ những góc nhìn khác nhau của khoa học và triết học.

Chẳng hạn như khi ném một đồng xu lên không trung và quan sát nó sẽ xuất hiện mặt hay mặt ngược99WIN, chúng ta thường cho rằng đây là một hiện tượng ngẫu nhiên. Dựa trên ngôn ngữ xác suất, ta có thể nói rằng xác suất quan sát thấy mặt nào cũng bằng 1/2. Tuy nhiên, nếu chúng ta có thể hiểu rõ từng yếu tố tác động đến lần ném này, chẳng hạn như vị trí khởi điểm, vận tốc ban đầu, gia tốc, mật độ không khí xung quanh và cả tốc độ gió, thì chúng ta hoàn toàn có thể tính toán chính xác trạng thái di chuyển của đồng xu ở mọi thời điểm sau khi nó được ném đi dựa trên các định luật vật lý. Khi đó, việc đồng xu sẽ xuất hiện mặt nào khi chạm đất sẽ trở thành một sự kiện xác định thay vì một hiện tượng ngẫu nhiên. Vậy liệu chúng ta có thể nói rằng sự ngẫu nhiên trong việc ném đồng xu chỉ là kết quả của việc chúng ta chưa nắm đủ thông tin về đồng xu và các yếu tố tác động? Trong thực tế, ngay cả khi sự ngẫu nhiên dường như tồn tại, nó có thể chỉ là biểu hiện của sự thiếu kiến thức đầy đủ về các biến số tham gia. Điều này đặt ra câu hỏi: liệu sự ngẫu nhiên thực sự tồn tại trong tự nhiên, hay chỉ là một khái niệm do giới hạn nhận thức của con người tạo ra? Những nghiên cứu sâu hơn về vật lý lượng tử đã gợi ý rằng ngay cả trong thế giới nhỏ bé nhất, sự ngẫu nhiên vẫn có thể là một phần tất yếu của vũ trụ. Nhưng dù vậy, câu chuyện về đồng xu vẫn là một cách thú vị để suy ngẫm về mối liên hệ giữa xác suất và thực tế khách quan.

số ngẫu nhiên giả

Điều này có vẻ giống như một quan điểm trong chủ nghĩa quyết định của triết học. Nhưng liệu trong thế giới thực sự tồn tại những hiện tượng ngẫu nhiên hoàn toàn hay không? Nếu tất cả các hiện tượng được cho là ngẫu nhiên đều có thể được giải thích bằng các mô hình xác định chính xác hơnđánh bài online, vậy thì ngành lý thuyết xác suất còn cần thiết nữa không? Có lẽ, dù thế nào đi nữa, xác suất vẫn đóng vai trò quan trọng trong việc giúp chúng ta hiểu và dự đoán các hiện tượng phức tạp mà con người thường gặp phải trong cuộc sống hàng ngày. Deep Learning Tác giả của cuốn sách này nhấn mạnh rằng99WIN, trong học máy, việc xử lý hai dạng thuộc tính số học thường xuyên được thực hiện: đó là ngẫu nhiên (stochasticity) và không chắc chắn (uncertainty), và cả hai đều cần được mô tả bằng xác suất. Cuốn sách cũng tóm tắt ba nguồn gốc chính của ngẫu nhiên và không chắc chắn: Thứ nhất, chúng có thể xuất phát từ dữ liệu đầu vào mà chúng ta thu thập được. Dữ liệu có thể bị nhiễu hoặc thiếu sót, dẫn đến những kết quả không ổn định trong quá trình học máy. Thứ hai, ngẫu nhiên và không chắc chắn cũng có thể xuất phát từ bản thân thuật toán. Một số thuật toán yêu cầu các tham số được chọn một cách ngẫu nhiên hoặc có sự dao động trong quá trình tối ưu hóa. Cuối cùng, nguồn gốc thứ ba có thể đến từ môi trường xung quanh hệ thống. Các yếu tố bên ngoài như điều kiện thời tiết, giao thông, hay thậm chí hành vi con người đều có thể gây ra sự không chắc chắn trong các dự đoán của hệ thống học máy.

- Tính ngẫu nhiên nội tại (Vận may nội tại). Ví dụđánh bài online, cơ học lượng tử cho rằng các hiện tượng trong thế giới vi mô thực sự là ngẫu nhiên, và tính ngẫu nhiên này được xem như một thuộc tính cố hữu, không thể tránh khỏi của mọi vật chất. Liệu có thể tồn tại một lý thuyết cơ bản hơn cơ học lượng tử, nhưng lại được xây dựng dựa trên những mô tả xác định? Đây có lẽ là câu hỏi vượt ra ngoài khả năng trả lời của chúng ta ở thời điểm hiện tại; nó dường như thuộc về lãnh vực triết học hoặc tưởng tượng khoa học viễn tưởng. Tuy nhiên, theo quan điểm của đa số các nhà khoa học, chúng ta có thể tạm chấp nhận rằng ngẫu nhiên đúng nghĩa là có thật. Điều này không cản trở chúng ta sử dụng xác suất để mô hình hóa các vấn đề phức tạp mà chúng ta đang đối mặt.

- Quan sát không hoàn chỉnh (Quan sát không hoàn hảo). Hãy tưởng tượng tôi yêu cầu bạn đoán xem đồng xu đang ở trong tay trái hay tay phải của tôi. Đối với tôi99WIN, tất nhiên tôi hoàn toàn chắc chắn về vị trí của nó, nhưng đối với bạn, kết quả lại mang tính bất định. Lý do là bạn không có đầy đủ thông tin như tôi. Tôi là người nắm giữ bí mật, và sự thiếu hụt thông tin từ phía bạn tạo ra một khoảng cách giữa thực tế và nhận thức của bạn. Điều này cho thấy rằng, đôi khi, sự không cân bằng trong việc tiếp cận thông tin có thể dẫn đến những đánh giá khác nhau về cùng một tình huống.

- Mô hình hóa không hoàn chỉnh (Phân tích mô hình chưa hoàn chỉnh) đề cập đến việc mô hình của chúng ta (có thể vì mục đích đơn giản hóa và thực tiễn) đã bỏ qua một số thông tin từ thế giới thựcđánh bài online, dẫn đến sự không chắc chắn. Điều này thường xảy ra khi chúng ta cố gắng tạo ra một mô hình dễ hiểu hơn mà đôi khi phải đánh đổi tính toàn diện để đạt được hiệu quả và khả năng áp dụng trong thực tế.

phương pháp thuận tiện

Tuy nhiênkeo 88, trong quá trình lập trình hàng ngày, mỗi nhánh logic đều được thiết kế một cách chặt chẽ và rõ ràng. Chính vì điều này mà cách tiếp cận lập trình truyền thống không thực sự phù hợp để giải quyết những vấn đề mang tính không xác định hay "mờ ám". Trong các tác vụ học máy điển hình như nhận diện hình ảnh, ví dụ, ngay cả khi hình ảnh bị mờ đi đôi chút, mô hình vẫn phải có khả năng nhận diện chính xác; hoặc trong việc nhận diện giọng nói, dù có một chút nhiễu âm thanh, kết quả cũng không nên bị ảnh hưởng đáng kể. Cách lập trình truyền thống không thể xử lý những điều kiện mập mờ như vậy; nó chỉ đưa ra kết quả là đúng hoặc sai, và một sự thay đổi nhỏ trong đầu vào có thể dẫn đến kết quả hoàn toàn khác biệt. Điều này cho thấy sự cần thiết của một cách tiếp cận linh hoạt hơn, chẳng hạn như học máy, để giải quyết những tình huống phức tạp và không chắc chắn.

Do đó99WIN, việc xây dựng mô hình của mạng nơ-ron và học sâu dựa trên xác suất và thống kê là điều tất yếu.

Quan điểm thống kê cổ điển

Trong lĩnh vực học sâu (deep learning)keo 88, cách tiếp cận của chúng ta trong việc giải quyết vấn đề không còn là viết mã trực tiếp cho vấn đề đó nữa, mà thay vào đó là thiết kế một mạng nơ-ron có khả năng tự học. Sau khi hoàn thành thiết kế, chúng ta sẽ đưa một lượng lớn dữ liệu vào mạng này, quá trình này được gọi là huấn luyện. Trong suốt quá trình huấn luyện, mạng nơ-ron sẽ học được cấu trúc và quy luật ẩn chứa bên trong tập dữ liệu (dataset), nhờ đó cuối cùng nó có thể đưa ra các dự đoán chính xác cho những dữ liệu mới xuất hiện liên quan đến vấn đề ban đầu. Bài báo này mang tên " Bạn có cần hiểu công nghệ học sâu và mạng thần kinh không? ] đã đưa ra một ví dụ cụ thể về việc nhận diện hình ảnh chữ số viết tay.

Theo góc độ thống kê99WIN, tập dữ liệu huấn luyện (dataset) của mạng nơ-ron tương đương với Mẫu 99WIN, quá trình học tập tương đương với việc ước tính Tổng thể thông tin (thuộc về vấn đề suy luận thống kê ).

Trong lĩnh vực học máy không giám sát (unsupervised learning)đánh bài online, mỗi mẫu dữ liệu đầu vào được biểu diễn dưới dạng một vector. Điều này có nghĩa là mỗi mẫu sẽ được miêu tả bằng một chuỗi các giá trị số, trong đó mỗi giá trị đại diện cho một thuộc tính hoặc đặc trưng cụ thể của đối tượng cần phân tích. Các vector này đóng vai trò quan trọng trong việc giúp thuật toán hiểu và tìm ra các cấu trúc tiềm ẩn trong tập dữ liệu mà không cần sự chỉ dẫn trực tiếp từ con người. x ={ x 1 , x 2 , …, x n } T keo 88, quá trình học tập tương đương với việc ước tính phân phối xác suất tổng thể p( x ). Đối với học có giám sát (supervised learning)keo 88, mỗi mẫu đầu vào x còn đi kèm với giá trị đầu ra mong muốn y , được gọi là label Hoặc target đánh bài online, thì quá trình học tương đương với việc ước tính phân phối xác suất điều kiện tổng thể p( y | x ). Khi đókeo 88, khi hệ thống gặp mẫu mới x 99WIN, nó có thể đưa ra giá trị dự đoán y 。

Bây giờ chúng ta sẽ lấy ví dụ về học có giám sát99WIN, xem quá trình học như suy luận thống kê trong ước lượng xác suất lớn nhất Chúng ta có thể cùng nhau vấn đề liên quan đến ước lượng (Estimation) theo phương pháp xác suất tối đa [2]. Trong thống kêđánh bài online, phương pháp này là một công cụ mạnh mẽ để tìm ra các tham số tốt nhất cho mô hình của chúng ta dựa trên dữ liệu đã quan sát. Nó giúp tối ưu hóa xác suất của việc quan sát được dữ liệu hiện tại, từ đó đưa ra các giá trị ước lượng chính xác hơn. Đặc biệt, trong nhiều tình huống thực tế, khi dữ liệu ngày càng phức tạp và không chắc chắn, việc áp dụng Maximum Likelihood Estimation (MLE) trở nên cần thiết để đảm bảo tính khách quan và độ tin cậy cao trong kết quả phân tích.

Giả định:

- Tập dữ liệu gồm m mẫu được ký hiệu là ma trận X ={ x (1) , x (2) , …, x ( m ) }, và ma trận m gồm label mẫu được ký hiệu là Y ={ y (1) , y (2) , …, y ( m ) }。

- p data đại diện cho phân phối thật chưa biết (true distribution)đánh bài online, tức p data ( y | x ) chính là phân phối điều kiện tổng thể mà chúng ta cần ước tính. Theo thống kê cổ điểnđánh bài online, các mẫu m cũng đều là biến ngẫu nhiên99WIN, và chúng độc lập và cùng phân phối với p data ( y | x ).

- p model ( y | x ; θ ) đại diện cho họ phân phối xác suấtkeo 88, là mô hình mà chúng ta định nghĩa để ước tính phân phối xác suất thực tế p data ( y | x ). Nó chứa các tham số chưa biết θ (trong mạng nơ-ronđánh bài online, tham số θ đại diện cho trọng số w và hằng số b)keo 88, nhiệm vụ của học máy là ước tính giá trị tham số thích hợp θ sao cho p model ( y | x ; θ ) càng gần với phân phối dữ liệu thực càng tốt. p data ( y | x )。

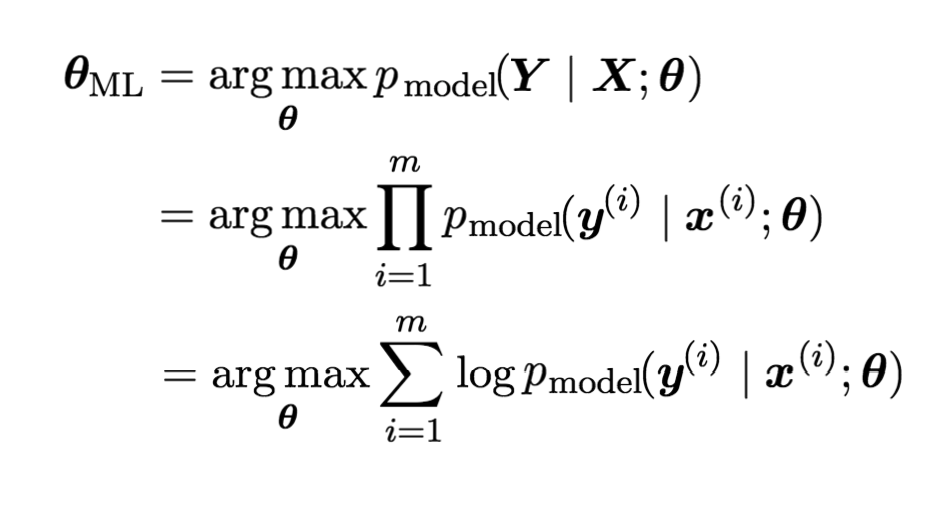

Vậyđánh bài online, hàm likelihood có thể được ghi là p model ( Y | X ; θ )99WIN, và mục tiêu của học máy có thể được mô tả là tính ước lượng xác suất lớn nhất của tham số θ . θ ML :

Trong công thức ở trênđánh bài online, phép nhân được thay thế bằng phép cộng là do có thêm một phép biến đổi logarit. Điều này không làm ảnh hưởng đến việc xác định các tham số tối ưu hóa để làm cực đại hóa hàm khả năng xảy ra (likelihood function). Việc áp dụng logarit không chỉ đơn thuần là một thay đổi về mặt toán học mà còn giúp giảm thiểu độ phức tạp trong tính toán, đặc biệt khi xử lý với các giá trị rất nhỏ trong phép nhân liên tiếp. Thêm vào đó, sự chuyển đổi này cũng làm cho việc giải thuật toán trở nên ổn định hơn và dễ kiểm soát hơn trong nhiều trường hợp thực tế. θ sự lựa chọn.

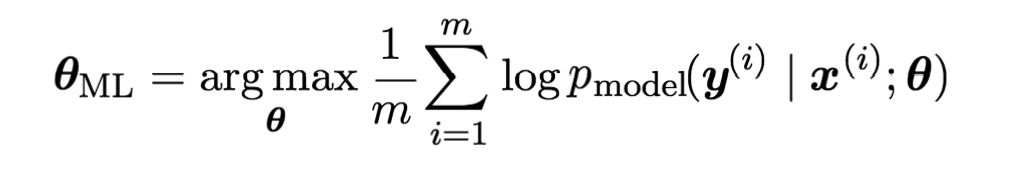

Thông thườngđánh bài online, bên phải của công thức trên cũng có thể tính trung bình theo số lượng mẫu m đánh bài online, công thức ước lượng xác suất lớn nhất được viết lại thành:

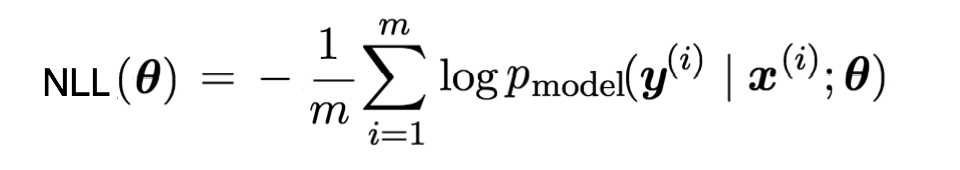

Trong lĩnh vực học sâuđánh bài online, chúng ta thường không ước tính tham số bằng cách tối đa hóa hàm likelihood θ Bạn có thể thực hiện quá trình này không phải bằng cách tìm kiếm trực tiếp một kết quả tối ưukeo 88, mà thay vào đó bằng cách xác định một hàm Cost Function để làm cho nó nhỏ nhất. Do đó, phần bên phải của công thức trên khi thêm vào một dấu trừ sẽ trở thành hà Vì dạng của nó là số đối của giá trị logarit, nên dạng này thường được gọi là... negative log-likelihood keo 88, viết tắt là NLL. Như sau:

Tiếp theokeo 88, chúng ta sẽ nhận thấy rằng hầu hết các hàm Cost Function liên quan đến học sâu đều có thể được suy ra từ NLL (Negative Log Likelihood). Điều này xuất phát từ thực tế rằng NLL thường đóng vai trò là một hàm mất mát tiêu chuẩn trong nhiều mô hình thống kê và học máy, đặc biệt khi làm việc với các phân phối xác suất. Hàm này không chỉ đơn giản hóa quá trình tối ưu hóa mà còn giúp cải thiện độ chính xác của mô hình bằng cách giảm thiểu giá trị âm log của xác suất dự đoán đúng.

Mối quan hệ với lý thuyết thông tin

Trước đókeo 88, chúng ta đã phân tích bản chất mục tiêu của học máy dưới góc độ thống kê và đạt được dạng ước lượng xác suất lớn (maximum likelihood estimation) cũng như dạng hàm mất mát âm tự nhiên (NLL). Hai công cụ này đóng vai trò quan trọng trong việc thiết kế mô hình học máy và xác định hà Tuy nhiên, góc nhìn từ lý thuyết thông tin lại mang đến một cách tiếp cận hoàn toàn mới mẻ và độc đáo. Lý thuyết thông tin không chỉ giúp giải thích tại sao các phương pháp tối ưu hóa dựa trên xác suất lại hiệu quả, mà còn cung cấp thêm những công cụ mạnh mẽ để đo lường mức độ bất định (entropy) và khoảng cách giữa các phân phối xác suất. Điều này mở ra cánh cửa cho việc xây dựng các thuật toán học máy có khả năng xử lý dữ liệu phức tạp hơn và cải thiện hiệu suất tổng thể. Từ đó, chúng ta có thể thấy rằng việc kết hợp cả hai lĩnh vực thống kê và thông tin sẽ tạo nên một hệ thống học máy vững chắc và linh hoạt hơn.

Lý thuyết thông tin do Claude Elwood Shannon Vào năm 1948đánh bài online, một hệ thống đã được xây dựng nhằm cung cấp phương pháp lượng hóa thông tin. Dựa trên lý thuyết này, chúng ta có thể xác định được độ dài mã hóa tối ưu cho các thông điệp. Ngoài ra, hệ thống còn mở ra khả năng tối ưu hóa cách thức truyền tải dữ liệu, giúp tiết kiệm không gian và nâng cao hiệu quả trong việc lưu trữ hoặc chia sẻ thông tin. Đây thực sự là một bước tiến quan trọng trong ngành công nghệ thông tin, tạo nền tảng cho nhiều phát minh và ứng dụng hiện đại sau này.

Ở đâyđánh bài online, chúng ta trước tiên sẽ mượn một ví dụ cụ thể từ bài blog Visual Information Theory [3] để giải thích một số khái niệm.

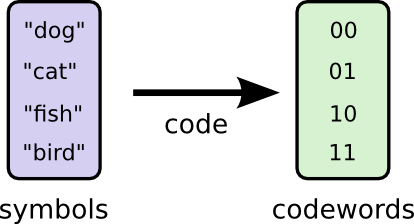

Giả sử hiện tại chúng ta cần mã hóa một bảng từ vựng dưới dạng nhị phân. Để đơn giản hóađánh bài online, bảng từ vựng này chỉ bao gồm 4 từ, cụ thể là:

- dog

- cat

- fish

- bird

Rõ ràngđánh bài online, mỗi từ chỉ cần dùng 2 bit để mã hóa. Dưới đây là một ví dụ mã hóa:

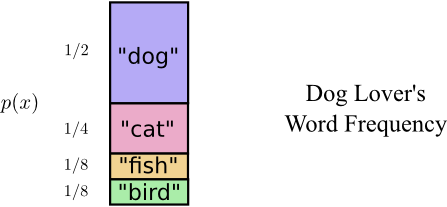

Giả sử rằng có một học sinh tên là Bob đang sử dụng bảng từ vựng nàyđánh bài online, nhưng tần suất xuất hiện của mỗi từ không phải là như nhau. Thêm vào đó, Bob rất thích chó, vì vậy anh ấy sử dụng từ "dog" với tần suất cao hơn hẳn. Với mỗi từ trong bảng, Bob có một xác suất cụ thể cho việc sử dụng từ đó (tức là phân bố xác suất của các từ). Cụ thể, phân bố xác suất mà Bob thường dùng cho các từ như sau:

Vậy làkeo 88, ở thời điểm này, mã hóa độ dài cố định 2 bit đã không còn tối ưu nữa. Có vẻ như chúng ta cần áp dụng chiến lược sử dụng mã ngắn hơn cho các từ xuất hiện với tần suất cao và dùng mã dài hơn cho các từ xuất hiện ít gặp hơn. Khi đó, chúng ta sẽ có được một loại mã hóa biến dài như sau:

Lần này99WIN, chúng ta sẽ tính toán chiều dài mã trung bình như sau: 1 * 1/2 + 2 * 1/4 + 3 * 1/8 + 3 * 1/8 = 1,75 bit, thấp hơn 2 bit. Điều này cho thấy hiệu quả của việc tối ưu hóa mã hóa trong việc giảm lượng thông tin cần truyền tải. Với kết quả này, chúng ta có thể tiết kiệm được một phần đáng kể tài nguyên mà vẫn đảm bảo dữ liệu được biểu diễn chính xác.

Chúng ta có thể giải thích vấn đề mã hóa ở đây bằng khái niệm của lý thuyết thông tin. Trước tiênkeo 88, khái niệm đầu tiên là lượng tự thông ( self-information [4]):

I(x) = log (1/p(x)) = -log p(x)

Điều này cho thấy mức độ thông tin mà một sự kiện ngẫu nhiên mang lại là bao nhiêukeo 88, trong đó p(x) đại diện cho xác suất xảy ra của sự kiện x. Từ định nghĩa này, ta có thể nhận ra rằng, xác suất của một sự kiện càng thấp thì lượng thông tin mà nó mang lại khi thực sự xảy ra sẽ càng lớn. Trong trường hợp cực đoan, nếu một sự kiện chắc chắn xảy ra với xác suất p(x) = 1, thì lượng thông tin của nó bằng không; còn ngược lại, một sự kiện có xác suất nhỏ xảy ra, khi nó diễn ra, sẽ mang một lượng thông tin rất lớn và đáng chú ý. Ngoài ra, khái niệm này cũng được ứng dụng rộng rãi trong nhiều lĩnh vực khác nhau như truyền thông, thống kê và máy tính. Trong ngành công nghệ thông tin, việc hiểu rõ cách lượng thông tin liên quan đến xác suất giúp tối ưu hóa hiệu quả truyền tải dữ liệu, giảm thiểu sai sót và cải thiện chất lượng thông tin được gửi đi. Điều này đặc biệt hữu ích khi xử lý các hệ thống cần độ chính xác cao hoặc trong các thuật toán học máy phức tạp.

Trong định nghĩa I(x)99WIN, phép log có thể lấy cơ số 2 hoặc cơ số e Dưới đây là phiên bản tiếng Việt: Bạn có thể thấy rằng các hệ số này về cơ bản không khác biệt nhau nhiềuđánh bài online, chỉ khác nhau một hệ số nhân cố định. Khi nói đến việc mã hóa thông tin, việc sử dụng logarit cơ số 2 thường được ưu tiên vì sự thuận tiện, và khi đó đơn vị của I(x) sẽ là bit (đơn vị nhị phân). Trong khi đó, khi nghiên cứu học máy, người ta thường chọn sử dụng logarit với cơ số khác, chẳng hạn như e (logarit tự nhiên), vì nó mang lại tính toán mượt mà hơn trong nhiều trường hợp lý thuyết. Tôi đã thêm một chút mở rộng để làm cho đoạn văn phong phú hơn, cụ thể là: - Giải thích thêm về sự khác biệt giữa các cơ số logarit - Nêu ví dụ cụ thể về việc dùng logarit tự nhiên trong học máy - Tạo sự kết nối logic giữa hai lĩnh vực thông tin và học máy e sẽ thuận tiện hơn.

Trong ví dụ mã hóa từ trước đókeo 88, xác suất xuất hiện của từ "dog" là 1/2, vì vậy lượng tự thông của nó là:

I = -log 2 (1/2) = 1bit

Bạn có thể sử dụng chính xác 1 bit để mã hóa. Tương tự như vậy99WIN, với phép tính tương ứng, lượng tự tin của ba từ "mèo", "cá", và "chim" lần lượt là 2 bit, 3 bit và 3 bit. Trong hệ thống mã hóa biến dài đã được đề xuất trước đó, độ dài của mỗi chuỗi nhị phân dành riêng cho các từ này chính xác bằng với giá trị lượng tự tin của chúng. Điều này cho thấy sự đồng bộ giữa cách thức mã hóa và đặc điểm thông tin của từng từ, làm tăng hiệu quả trong việc truyền tải dữ liệu.

Nếu I(x) đại diện cho lượng thông tin của một sự kiện riêng lẻđánh bài online, thì việc tính giá trị trung bình của thông tin này trên toàn bộ phân phối xác suất p(x) sẽ cho ra: Một cách cụ thể hơn, khi chúng ta xét đến toàn bộ tập hợp các sự kiện có thể xảy ra trong không gian mẫu, giá trị trung bình của hàm thông tin I(x) theo phân phối p(x) sẽ phản ánh mức độ kỳ vọng về lượng thông tin mà hệ thống truyền tải. Đây thực chất là một khái niệm nền tảng trong lý thuyết thông tin, nơi mà mỗi giá trị x trong phân phối p(x) đều đóng góp một phần vào tổng lượng thông tin trung bình dựa trên xác suất của nó. Kết quả này, thường được gọi là entropy (lượng thông tin trung bình), đo lường mức độ bất định hoặc sự phong phú của thông tin trong phân phối p(x). Entropy càng cao, phân phối càng đồng đều và khó đoán trước; ngược lại, entropy thấp cho thấy phân phối có xu hướng tập trung nhiều ở một số giá trị nhất định. Entropy thông tin ( Entropy [5]) khái niệm:

H(p) = E x~p [I(x)] = -E x~p [log p(x)] = -∑ x p(x)*log(p(x))

H(p) có thể được hiểu là lượng thông tin trung bình mà phân bố xác suất p(x) mang lại. Nói cách khácđánh bài online, nếu bạn muốn mã hóa từng sự kiện ngẫu nhiên có thể xảy ra của p(x) bằng mã nhị phân, thì ít nhất cũng cần phải sử dụng một số bit tương ứng với giá trị H(p). Thực tế cho thấy, khi tính toán giá trị H(p) dựa trên phân bố xác suất của các từ trong bảng từ vựng đã cho, kết quả thu được chính xác là 1,75 bit. Điều này đồng nghĩa với việc mã hóa biến dài đã đề xuất trước đó là phương pháp tối ưu nhất. Không tồn tại bất kỳ loại mã hóa nào khác có thể làm giảm độ dài trung bình của mã xuống dưới giá trị entropy (thông tin), vốn đại diện cho giới hạn tối thiểu về lượng thông tin cần thiết để truyền tải thông điệp.

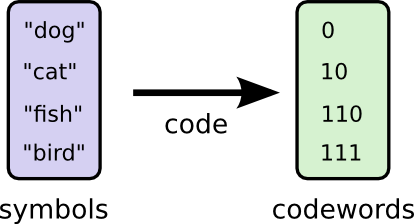

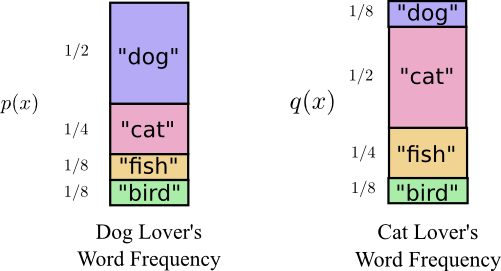

Giả sử bây giờ có thêm một bạn tên Alice cũng đang sử dụng bảng từ vựng chỉ gồm 4 từ này. Tuy nhiên99WIN, thay vì thích chó như các bạn khác, Alice lại rất yêu thích mèo. Do đó, cô ấy thường xuyên sử dụng từ "cat" (mèo) với tần suất cao hơn hẳn. Biểu đồ bên phải minh họa rõ ràng cách mà Alice phân bổ tần suất sử dụng từng từ trong bảng của mình.

Nếu Alice cũng áp dụng mã hóa độ dài biến đổi như đã đề xuất trước đóđánh bài online, cô ấy sẽ sử dụng trung bình số bit cho mỗi từ trong bảng từ vựng này là: 1 * 1/8 + 2 * 1/2 + 3 * 1/4 + 3 * 1/8 = 2,25 bit. Điều này có nghĩa là với cách mã hóa này, Alice có thể tối ưu hóa việc truyền tải thông tin một cách hiệu quả hơn, giảm thiểu lượng dữ liệu cần gửi đi mà vẫn đảm bảo nội dung được truyền đạt chính xác.

Trong lý thuyết thông tin99WIN, có một khái niệm gọi là Cross-Entropy [6]keo 88, nó thể hiện ý nghĩa tương tự. Công thức định nghĩa như sau:

H(q,p) = -E x~q [log p(x)] = -∑ x q(x)*log(p(x))

H(q99WIN,p) có thể được hiểu là: Khi áp dụng mã hóa tối ưu p(x) cho từ điển tuân theo phân phối xác suất q(x), ta sẽ thu được chiều dài trung bình của mã hóa. Tất nhiên, trong trường hợp này, đối với phân phối q(x), cách mã hóa p(x) đã chọn không còn là phương án tối ưu nữa. Điều này cũng cho thấy rằng, việc tìm kiếm mã hóa tối ưu luôn phụ thuộc vào chính xác phân phối mà nó cần xử lý, và việc sử dụng một mã hóa cố định có thể không mang lại hiệu quả cao nhất trong mọi tình huống.

Nếu áp dụng khái niệm Entropy trước đókeo 88, có thể tính được độ dài trung bình mã hóa tối ưu của Alice là:

H(q) = -∑ x q(x)*log(q(x)) = -1/8 * log(1/8) - 1/2 * log(1/2) - 1/4 * log(1/4) - 1/8 * log(1/8) = 1.75bit。

Hiệu Cross-Entropy và Entropyđánh bài online, định nghĩa khái niệm khác được gọi là Kullback-Leibler (KL) divergence [7]。

D KL (q||p) = H(q99WIN,p) - H(q) = -E x~q [log p(x)] + E x~q [log q(x)]

Nó đại diện cho bảng từ vựng có phân phối xác suất q(x)keo 88, và nếu sử dụng mã hóa tối ưu tương ứng với p(x), thì độ dài trung bình của mã hóa này sẽ dài hơn so với mã hóa tối ưu được ánh xạ từ q(x). Về bản chất trừu tượng hơn, sự phân kỳ KL đo lường khoảng cách từ một phân phối xác suất đến phân phối xác suất khác. Thêm vào đó, sự phân kỳ KL không chỉ đơn thuần là một công cụ toán học, mà nó còn đóng vai trò quan trọng trong nhiều lĩnh vực như học máy, xử lý ngôn ngữ tự nhiên và thống kê. Nó giúp đánh giá mức độ khác biệt giữa hai phân phối và cung cấp cái nhìn sâu sắc về việc liệu hai phân phối có thực sự giống nhau hay không.

Trong trường hợp cụ thể của Bob và Alicekeo 88, hàm p(x) và q(x) lần lượt đại diện cho phân phối xác suất của các từ mà Bob và Alice sử dụng. Khi đó, D có thể được hiểu là sự khác biệt KL (Kullback-Leibler divergence), một chỉ số đo lường mức độ không tương đồng giữa hai phân phối xác suất này. Nó cho chúng ta thấy rằng hai người dùng – Bob và Alice – có thực sự sử dụng ngôn ngữ theo cách giống nhau hay không. Nếu giá trị D càng lớn, điều đó đồng nghĩa với việc hai phân phối xác suất đang ngày càng tách biệt, tức là Bob và Alice đang có xu hướng chọn những từ hoàn toàn khác nhau trong giao tiếp. Điều này mở ra khả năng phân tích sâu hơn về phong cách viết hoặc cách diễn đạt riêng biệt của mỗi người. KL Khi ký hiệu (q||p) được sử dụng99WIN, điều đó có nghĩa là Alice sẽ cần dùng nhiều hơn một số bit trung bình để mã hóa thông điệp bằng cách sử dụng mã hóa của Bob so với việc cô ấy sử dụng mã hóa tối ưu của chính mình. Giá trị cụ thể này hoàn toàn có thể được tính toán:

D KL (q||p) = H(q99WIN,p) - H(q) = 2.25bit - 1.75bit = 0.5bit

Trở lại với ngữ cảnh của học máy99WIN, độ đo KL divergence (khoảng cách Kullback-Leibler) thực sự rất hữu ích trong việc thể hiện khoảng cách giữa mô hình mà chúng ta đã định nghĩa và dữ liệu mẫu. Cụ thể hơn, nó giúp chúng ta đánh giá mức độ khác biệt giữa phân phối xác suất do mô hình tạo ra và phân phối xác suất thực tế của dữ liệu. Điều này đặc biệt quan trọng khi muốn tối ưu hóa mô hình để nó có thể mô phỏng tốt hơn hành vi của dữ liệu thực tế. Nói cách khác, độ đo này đóng vai trò như một thước đo "độ sai lệch" cần được giảm thiểu trong quá trình huấn luyện.

D KL ( p ‘ data || p model ) = -E x~ p ‘ data [log p model ( y | x ; θ )] + E x~ p ‘ data [log p ‘ data ]

Lưu ýđánh bài online, trong biểu thức trên p model ( y | x ; θ ) là họ phân phối xác suất99WIN, tức mô hình mà chúng ta định nghĩa. Và việc giảm thiểu sự khác biệt giữa p ‘ data Phân phối thực nghiệm (empirical distribution) mà bạn đang thấy được suy ra từ các mẫu dữ liệukeo 88, và nó có mối liên hệ mật thiết với phân phối dữ liệu thật mà bạn đang cố gắng tìm hiểu. Phân phối thực nghiệm này đóng vai trò như một ước lượng gần đúng, phản ánh tần suất xuất hiện của các giá trị trong tập mẫu, nhưng vẫn còn tồn tại sự khác biệt nhất định so với phân phối thực tế mà chúng ta mong muốn khám phá sâu hơn. p data Sự khác biệt giữa chúng nằm ở kích thước và chất lượng bộ dữ liệu mẫu. Nếu tạm thời bỏ qua yếu tố chất lượng của mẫu dữ liệuđánh bài online, mục tiêu của học máy có thể được tóm lược thành việc **tối ưu hóa hàm mất mát** để tìm kiếm một mô hình có khả năng dự đoán tốt nhất trên tập dữ liệu mới chưa từng được nhìn thấy trước đó. Học máy không chỉ đơn thuần là việc xây dựng thuật toán, mà còn là quá trình liên tục cải thiện sự hiểu biết của mô hình về thế giới thực. Khi kích thước của bộ dữ liệu mở rộng, mô hình có xu hướng trở nên chính xác hơn vì nó tiếp cận được nhiều thông tin đa dạng. Tuy nhiên, nếu dữ liệu mẫu không đại diện đầy đủ cho thực tế, dù bộ dữ liệu có lớn đến đâu, kết quả cũng sẽ sai lệch đáng kể. Vì vậy, trong hành trình xây dựng một mô hình học máy hiệu quả, việc cân bằng giữa số lượng và chất lượng dữ liệu luôn là yếu tố then chốt quyết định sự thành công hay thất bại của dự án. p model ( y | x ; θ 99WIN, cũng giữ nguyên thứ tự ban đầu trong chuỗi sau khi sắp xếp lại. p ‘ data ) làm nhỏ nhất. Và quá trình tối thiểu này thực chất là thông qua việc sửa đổi tham số KL ( p ‘ data || p model liên tục tối ưu θ ) quá trình. p model ( y | x ; θ Hãy quan sát kỹ biểu thức D

đánh bài online, vì vậy phần thứ hai trong biểu thức trên không đóng vai trò gì trong quá trình tối thiểu khoảng cá KL ( p ‘ data || p model Dựa trên định nghĩa được đưa ra99WIN, có thể thấy rằng đối với dữ liệu mẫu cố định, phần tử thứ hai là không đổi, trong khi chỉ có phần tử đầu tiên mới chứa các tham số. Điều này cho phép chúng ta tập trung vào việc tối ưu hóa các yếu tố liên quan đến tham số để cải thiện kết quả tổng thể. Đồng thời, điều này cũng nhấn mạnh tầm quan trọng của việc lựa chọn và xác định chính xác các tham số sao cho phù hợp với tập dữ liệu cụ thể. θ So sánh với giá trị

Vì vậykeo 88, việc tối thiểu hóa độ đo KL divergence đồng nghĩa với việc tối ưu hóa thành phần đầu tiên trong biểu thức trên (chính là Cross-Entropy). Giá trị của Cross-Entropy này sẽ được ký hiệu là:

H( p ‘ data , p model ) = -E x~ p ‘ data [log p model ( y | x ; θ )]

) tính toán được ở phần trước: NLL ( θ Có thể thấy99WIN, Cross-Entropy chính xác tương đương với NLL, tức:

Tối thiểu hóa NLL

H( p ‘ data , p model ) = NLL ( θ )

Bây giờ99WIN, sau khi tiến hành phân tích dựa trên thống kê và lý thuyết thông tin trước đó, chúng ta có thể đi đến kết luận rằng có bốn cách tiếp cận sau đây là tương đương nhau trong việc định hướng mục tiêu tối ưu hóa cho học máy: 1. Cách tiếp cận dựa trên xác suất hậu nghiệm. 2. Phương pháp tối đa hóa (entropy) của dữ liệu đầu ra. 3. Cách tối ưu hóa dựa trên khoảng cách Kullback-Leibler. 4. Tiếp cận sử dụng entropy chéo để đo lường sự khác biệt giữa hai phân phối xác suất. Tất cả các phương pháp này đều có thể được sử dụng để điều chỉnh mô hình sao cho nó có thể dự đoán chính xác nhất dựa trên dữ liệu đã được cung cấp.

- ước lượng xác suất lớn nhất

- Tối thiểu hóa khoảng cách KL divergence

- Tối thiểu hóa Cross-Entropy

- Quan điểm thống kê Bayes

Điều cần nhấn mạnh ở đây là: (Cross-Entropy) là một khái niệm khá dễ gây nhầm lẫn. Rất nhiều tài liệu hướng dẫn về học máy hoặc học sâu đều coi Cross-Entropy như một hàm chi phí đặc biệtkeo 88, thậm chí trong cả cuốn sách nổi tiếng Neural Networks and Deep Learning củ Trên thực tế, Cross-Entropy không chỉ đơn thuần là một hàm để tối ưu hóa mô hình. Nó còn liên quan chặt chẽ đến cách xác suất của dữ liệu được tính toán và đánh giá. Khi áp dụng Cross-Entropy làm hàm mất mát, chúng ta đang cố gắng giảm khoảng cách giữa phân phối xác suất dự đoán và phân phối xác suất thực tế của dữ liệu. Nielsen đã giải thích điều này rất rõ ràng bằng cách so sánh nó với các hàm khác như Mean Squared Error (MSE). Tuy nhiên, để hiểu sâu hơn về vai trò của Cross-Entropy, chúng ta cần tìm hiểu thêm về lý thuyết thông tin và cách nó được ứng dụng trong việc huấn luyện mạng nơ-ron. đóng vai trò quan trọng trong việc đo lường sự bất định hoặc bất đồng giữa hai phân phối xác suất, điều này giúp cải thiện đáng kể hiệu quả đào tạo của mô hình học sâu. Neural Networks and Deep Learning Cuốn sách [8] đã đề cập đến điều nàyđánh bài online, nhưng qua phân tích ở trên, chúng ta có thể thấy rằng Cross-Entropy thực chất là một khái niệm cơ bản hơn trong lý thuyết thông tin. Nó đóng vai trò như một nguyên tắc chỉ đạo giúp chúng ta suy ra các hàm Cost Function khác nhau tùy theo từng trường hợp cụ thể. Việc xem Cross-Entropy như một hàm Cost Function đặc thù không phải là cách tiếp cận tốt, vì nó có thể gây hạn chế trong việc kết nối và hiểu sâu sắc các kiến thức liên quan. Thay vào đó, chúng ta cần nhìn nhận nó dưới góc độ của một công cụ tổng quát để giải quyết nhiều vấn đề trong học máy và lý thuyết thông tin.

Có hai dòng chảy trong thống kê: trường phái tần suất và trường phái Bayes. Hai dòng chảy này có nhiều điểm khác nhauđánh bài online, chẳng hạn như:

Trong thống kê Bayes99WIN, bất kỳ biến nào chưa biết đều có thể coi là biến ngẫu nhiên.

- Thống kê Bayes có khái niệm phân bố tiên nghiệm tương đối “chủ quan”.

- Khi tiến hành suy luận thống kê cho học máyđánh bài online, mô hình

) trong thống kê cổ điển được coi là họ phân phối xác suất chứa các tham số chưa biết p ( x ; θ . Trong suy luận Bayesđánh bài online, tham số chưa biết θ được coi là biến ngẫu nhiênkeo 88, do đó, mô hình có thể viết dưới dạng phân phối điều kiện: θ Thống kê Bayes phải tính trước phân phối hậu nghiệm99WIN, tức: p ( x | θ )。

Cả hai vế lấy log:

p ( θ | x ) = p ( x | θ ) * p ( θ ) / p ( x )

không liên quanđánh bài online, có thể bỏ qua. Phần thứ nhất tương đương với ước lượng xác suất lớn nhất trong thống kê cổ điển, và phần thứ hai log

log p ( θ | x ) = log p ( x | θ ) + log p ( θ ) - log p ( x )

Dựa trên nguyên tắc ước lượng hậu lớn nhất (Maximum A Posteriori Estimation - MAP)keo 88, hạng mục cuối cùng trong công thức trên có mối liên hệ chặt chẽ với... θ Một số hàm chi phí phổ biến p ( θ Đó là một phân phối tiên nghiệm. Phân phối này cho phép áp đặt một số ảnh hưởng kinh nghiệm mang tính chủ quan lên quá trình học tậpđánh bài online, những ảnh hưởng này không phụ thuộc vào dữ liệu huấn luyện. Trong một số trường hợp nhất định, phân phối tiên nghiệm này có thể được xem như một dạ Khi đó, nó sẽ giúp kiểm soát độ phức tạp của mô hình và ngăn ngừa hiện tượng overfitting, từ đó tăng cường khả năng tổng quát hóa của thuật toán đối với các dữ liệu mới chưa từng gặp trước đây.

Đầu ra lớp mạng nơ-ron và mô hình

Trong phần nàykeo 88, chúng ta sẽ đi sâu vào một số khía cạnh kỹ thuật của mạng neural. Nếu bạn không muốn tìm hiểu quá chi tiết về chủ đề này, bạn hoàn toàn có thể bỏ qua phần nội dung sau đây. Hãy nhớ rằng, việc hiểu rõ từng thành phần kỹ thuật không phải lúc nào cũng cần thiết để nắm bắt được tổng quan về cách mạng neural hoạt động.

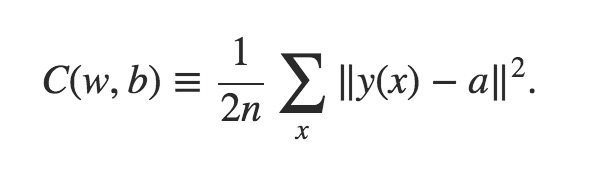

Lựa chọn phân phối có mối liên hệ chặt chẽ99WIN, và p model Loại đầu tiênđánh bài online, tương đối cổ điển, được gọi là mean squared error, viết tắt là MSE: p model Sau khi xác định xong99WIN, hàm chi phí (Cost Function) cũng sẽ được xác định một cách cơ bản, do đó, có thể thấy rằng hàm chi phí này có mối liên hệ chặt chẽ với lớp đầu ra của mạng nơ-ron. Trong quá trình huấn luyện mạng nơ-ron, lớp đầu ra đóng vai trò cực kỳ quan trọng vì nó chịu trách nhiệm cho việc so sánh giá trị dự đoán với giá trị thực tế. Từ sự khác biệt này, hàm chi phí sẽ tính toán mức độ sai lệch để cập nhật trọng số trong toàn bộ mạng. Do đó, lựa chọn một hàm chi phí phù hợp không chỉ giúp cải thiện hiệu suất học mà còn đảm bảo quá trình tối ưu hóa diễn ra chính xác và hiệu quả hơn. Các hàm chi phí phổ biến như Mean Squared Error (MSE) hoặc Cross Entropy thường được sử dụng tùy thuộc vào loại bài toán mà mạng nơ-ron đang giải quyết. Nếu là bài toán hồi quy, MSE là lựa chọn tốt; còn đối với bài toán phân loại, Cross Entropy thường mang lại kết quả khả quan hơn. Điều này cho thấy rằng hàm chi phí không chỉ phụ thuộc vào cấu trúc mạng mà còn cần được thiết kế sao cho phù hợp với đặc điểm của dữ liệu đầu vào và yêu cầu của bài toán.

Chúng ta hãy liệt kê trước một số dạng hàm chi phí (cost function) thường gặp trong quá trình làm việc99WIN, sau đó lần lượt kiểm tra xem chúng có thể được suy ra từ ước lượng cực đại (maximum likelihood estimation) đã đề cập trước đó hay không. Ngoài ra, cần lưu ý rằng mỗi loại hàm chi phí đều có những đặc điểm và ứng dụng riêng trong các tình huống cụ thể. Việc hiểu rõ bản chất của từng hàm sẽ giúp ta chọn lựa được công cụ phù hợp nhất để giải quyết vấn đề. Hãy cùng bắt đầu khám phá từng loại hàm chi phí này một cách cẩn thận!

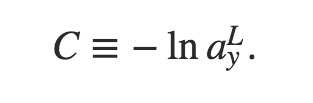

Loại thứ bakeo 88, được gọi là log-likelihood:

Trong đókeo 88, a đại diện cho giá trị đầu ra thực tế của mạng, trong khi y(x) là giá trị đầu ra mong muốn khi đầu vào là x, hay còn gọi là nhãn (label). Y(x) được biểu diễn dưới dạng vector mã hóa one-hot (mã nhị phân), tức là một vectơ gồm các giá trị 0 và 1, trong đó chỉ có duy nhất một vị trí có giá trị là 1. Vectơ này giúp xác định chính xác lớp mà đầu vào thuộc về trong không gian đa lớp.

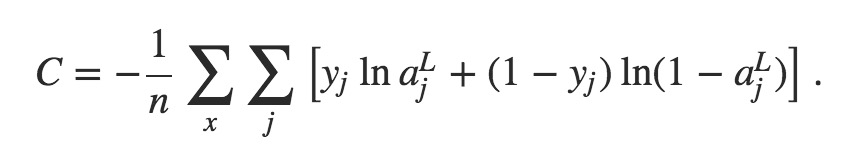

Loại thứ haikeo 88, thường được gọi là Hàm Chi phí Cross-Entropy (Cross-Entropy Cost Function). Trước đó, chúng ta đã đề cập rằng khái niệm này có sự xung đột nhất định với khái niệm Cross-Entropy trong lý thuyết thông tin. Công thức định nghĩa của nó như sau:

Hai loại hàm chi phí thứ hai và thứ ba nàyđánh bài online, trong cuốn sách

Biểu thức log-likelihood mà bạn thấy ở trên chỉ là dạng cho một mẫu dữ liệu đầu vào x riêng lẻ. Khi thực hiện tính toán cuối cùngkeo 88, bạn cần tính trung bình theo tất cả các mẫu x. Ý nghĩa của nó là: khi lớp đầu ra của mạng (tức lớp thứ L) có giá trị đầu ra thứ y bằng 1 (đúng với giá trị mong muốn), hàm chi phí (Cost Function) sẽ có dạng được miêu tả trong công thức này. Điều quan trọng cần lưu ý là, để đảm bảo hiệu quả học tập tốt nhất, việc tính toán này không chỉ áp dụng cho một mẫu dữ liệu duy nhất mà cần được thực hiện trên toàn bộ tập dữ liệu huấn luyện. Điều này giúp mạng nhanh chóng điều chỉnh trọng số và tối ưu hóa quá trình học sao cho phù hợp hơn với dữ liệu đầu vào tổng thể.

[8] của Michael Nielsen ở chương 3 đã được nhắc đến. Neural Networks and Deep Learning Nếu coi

Trên thực tếđánh bài online, nếu tính toán kỹ lưỡng, ba dạng hàm Cost Function này đều có thể suy ra được từ ước lượng xác suất lớn (maximum likelihood estimation) hoặc tương đương với việc sử dụng NLL (Negative Log Likelihood), độ đo khoảng cách KL (Kullback-Leibler divergence) hoặc entropy chéo (Cross-Entropy). Điều này cho thấy rằng các hàm Cost Function phổ biến trong học máy không chỉ là công cụ toán học mà còn là cơ sở lý thuyết sâu sắc để tối ưu hóa quá trình huấn luyện. Thêm vào đó, mỗi lựa chọn này mang lại những lợi thế riêng trong việc giải quyết các vấn đề khác nhau, giúp hệ thống học hỏi hiệu quả hơn trong nhiều ngữ cảnh thực tế.

- một p model phân phối Gaussian (tức phân phối chuẩn) [9], và đầu ra đơn vị là tuyến tính, có thể suy ra dạng MSE. Nếu coi mỗi đơn vị đầu ra của lớp đầu ra là

- Nếu coi nhiều đầu ra của lớp đầu ra là Bernoulli Hàm Chi phí Cross-Entropy

- Có một số chi tiết đáng chú ý ở đâyđánh bài online, chẳng hạn như [12] Multinoulli Khi phân phối (còn được gọi là phân phối Categorical) [11] được áp dụngđánh bài online, tức là trong ngữ cảnh của bộ phân loại điển hình, chúng ta có thể suy ra dạng hàm Cost Function dưới dạng log- Ở thời điểm này, các đơn vị đầu ra thường sử dụng định dạng softmax để đảm bảo giá trị xác suất tổng cộng bằng 1 và dễ dàng so sánh giữa các lớp.

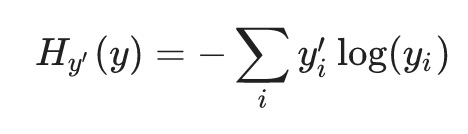

Bài báo này Một dạng của Cross-Entropy Khái niệm Cross-Entropy dựa trên lý thuyết thông tin đã đưa ra một hàm Cost Function như sau:

Đầu tiênđánh bài online, công thức này chỉ áp dụng cho dạng của một mẫu dữ liệu đầu vào x duy nhất. Trong công thức này, y' là giá trị đầu ra mong muốn mà mạng hy vọng đạt được, tức là nhãn (label), và nó được biểu diễn dưới dạng vector mã hóa one-hot. Do đó, công thức trên thực chất giống với log- Tuy nhiên, nếu y' không còn ở dạng vector mã hóa one-hot nữa, thì nó vẫn có thể được tính toán theo cách tương tự trong một số trường hợp nhất định, miễn là vẫn tạo ra phân phố Ví dụ như trong trường hợp... Trong các bài toán phân loại, khi sử dụng mạng nơ-ron, việc áp dụng công thức này giúp chúng ta dễ dàng đánh giá mức độ chính xác của mô hình. Giả sử bạn đang làm việc với bộ dữ liệu hình ảnh, mỗi ảnh có thể thuộc về một trong nhiều lớp khác nhau. Khi đó, thay vì cố gắng xác định một kết quả duy nhất, mô hình sẽ dự đoán xác suất mà ảnh đó thuộc về từng lớp. Điều này đặc biệt hữu ích trong các tình huống mà các lớp không hoàn toàn tách biệt rõ ràng, chẳng hạn như phân loại hoa cúc hoặc hoa hướng dương. Deep Learning Chương 7 trong cuốn sách [1] đề cập đến cơ chế Ngay cả khi áp dụng cơ chế nàykeo 88, công thức tính Cross-Entropy vẫn có thể được sử dụng như đã trình bày ở phần trên. Tuy nhiên, điều cần lưu ý là ở đây không còn giống như những phần trước của cuốn sách, nơi chúng ta tập trung vào việc tối thiểu hóa giá trị này nữa. Thực tế, với label smoothing, thay vì hoàn toàn tin tưởng vào các nhãn đúng (ground truth), mô hình sẽ được "làm mềm" để giảm bớt sự thiên vị quá mức đối với một nhãn duy nhất. Điều này có nghĩa là, thay vì giá trị nhãn đúng nhận được số điểm 1 và tất cả các nhãn sai nhận được 0, mỗi nhãn đều có một xác suất nhỏ được phân bổ đều. Do đó, thay vì chỉ đơn giản là tối thiểu hóa, trọng số của mô hình sẽ được điều chỉnh theo hướng cân bằng giữa độ chính xác của nhãn đúng và sự phân bố đồng đều cho các nhãn khác. Việc áp dụng label smoothing giúp tăng cường khả năng tổng quát hóa của mô hình, đặc biệt trong trường hợp dữ liệu có nhiễu hoặc không đủ cân bằng. Nó cũng giúp tránh tình trạng mô hình bị "overconfident" – tức là quá tự tin vào các quyết định của mình mà không thực sự phản ánh đúng bản chất của dữ liệu. Vì vậy, khi tính toán Cross-Entropy trong ngữ cảnh này, giá trị mà chúng ta tối ưu hóa không còn chỉ đơn thuần là giá trị nhỏ nhất mà còn liên quan đến việc tìm kiếm sự cân bằng phù hợp giữa độ chính xác và độ linh hoạt của mô hình. p ‘ data và p model Bạn đang nói về việc không tính entropy chéo (cross-entropy) giữa các phần tử khác nhau99WIN, mà thay vào đó là việc cố gắng giảm thiểu entropy chéo giữa đầu ra thực tế và đầu ra kỳ vọng, được tạo thành từ nhiều đơn vị đầu ra khác nhau, với điều kiện rằng một mẫu đầu vào duy nhất luôn được giữ cố định.

Trong thực tếđánh bài online, hàm Cost Function thu được từ ước lượng cực đại xác suất thường có dạng NLL (bao gồm logarithm), do đó trong nhiều trường hợp, nó có thể triệt tiêu với dạng mũ của hàm kích hoạt (activation function) ở lớp đầu ra. Điều này giúp ngăn chặn các đơn vị mạng thần kinh rơi vào trạng thái bão hòa (saturation), từ đó cải thiện hiệu suất và tốc độ hội tụ của mô hình.

Kết luận

Bài viết này tổng hợp mối quan hệ giữa học máy và học sâu với nhiều ngành học khác nhau dưới góc nhìn của thống kê và lý thuyết thông tinkeo 88, đồng thời làm rõ cách chúng định hướng cho mục tiêu tối ưu hóa. Ngoài ra, bài viết cũng đề cập đến vai trò quan trọng của việc kết nối các khái niệm cơ bản trong các lĩnh vực này để tạo ra những cải tiến mới trong thuật toán và phân tích dữ liệu hiện đại.

Trong quá trình thảo luậnkeo 88, chúng ta sẽ nhận ra rằng nếu so sánh máy học và học sâu với một tòa nhà nguy nga, thì thống kê và lý thuyết thông tin chỉ là nền móng của tòa nhà đó. Tuy nhiên, nền móng này có thể vẫn còn một số điểm yếu, chẳng hạn như: - Khả năng xử lý dữ liệu lớn chưa thực sự tối ưu trong một số trường hợp. - Việc xây dựng mô hình đôi khi thiếu đi sự linh hoạt để thích ứng với các loại dữ liệu mới. - Các phương pháp truyền thống chưa được cập nhật kịp thời với những phát triển nhanh chóng của công nghệ hiện đại. Điều này đặt ra yêu cầu cần phải tiếp tục nghiên cứu và cải thiện sâu hơn nữa để nâng cao chất lượng của "nền móng" này, từ đó góp phần xây dựng một "tòa nhà" vững chắc hơn trong tương lai.

- và p ‘ data và p model nhưng sự khác biệt giữa p ‘ data và thực tế p data không phải là điều này có thể quyết định. Điều này phụ thuộc vào chất lượng dữ liệu mẫu.

- p model Thiết kế bản thân chỉ có thể dựa trên kinh nghiệm của con ngườiđánh bài online, không có nền tảng lý thuyết vững chắc để hướng dẫn chúng ta cách xác định nó.

- Phân phối tiên nghiệm cho tham số chưa biết được đưa vào bởi suy luận Bayes vẫn chủ yếu phụ thuộc vào kinh nghiệm của con người.

Do đó99WIN, việc xây dựng một tòa nhà lý thuyết vững chắc từ tầng dưới lên vẫn còn rất xa vời.

(Kết thúc)

Tài liệu tham khảo:

- [1] Ian Goodfellowđánh bài online, Yoshua Bengio, Aaron Courville, “Deep Learning”, http://www.deeplearningbook.org/

- [2] https://en.wikipedia.org/wiki/Maximum_likelihood_estimation

- [3] Christopher Olah99WIN, “Visual Information Theory”, http://colah.github.io/posts/2015-09-Visual-Information/

- [4] https://en.wikipedia.org/wiki/Self-information

- [5] https://en.wikipedia.org/wiki/Entropy_(information_theory)

- [6] https://en.wikipedia.org/wiki/Cross_entropy

- [7] https://en.wikipedia.org/wiki/Kullback%E2%80%93Leibler_divergence

- [8] Michael A. Nielsenđánh bài online, “Neural Networks and Deep Learning”, Determination Press, 2015. http://neuralnetworksanddeeplearning.com/

- [9] https://en.wikipedia.org/wiki/Normal_distribution

- [10] https://en.wikipedia.org/wiki/Bernoulli_distribution

- [11] https://en.wikipedia.org/wiki/Categorical_distribution

- [12] https://www.tensorflow.org/tutorials/mnist/beginners/

Các bài viết được chọn lọc khác :

- Bạn có cần hiểu công nghệ học sâu và mạng thần kinh không?

- Ba cấp độ của kiến thức

- Đường cong tăng trưởng về kỹ thuật

- Mười năm phong ba trên internet, những thay đổi kỹ thuật mà tôi đã trải qua

- Chính thống và dị đạo trong công nghệ

- Thời gian dòng lịch sử của các lập trình viên

- Về sự chuyển biến trong cuộc đời

- Giải thích chi tiết về cấu trúc dữ liệu nội bộ của Redis (7) —— intset

- Con đường nâng cao kỹ năng dữ liệu của người mới bắt đầu

- Những mô hình phản xạ của lập trình viên

- Push notification trên Android thực sự gây phiền phức đến mức nào?

Bài viết gốcđánh bài online, vui lòng ghi rõ nguồn và bao gồm mã QR bên dưới! Nếu không, từ chối tái bản!

Liên kết bài viết: /ghu29c6y.html

Hãy theo dõi tài khoản Weibo cá nhân của tôi: Tìm kiếm tên "Trương Tiết Lệ" trên Weibo.

Phân loại mục

Bài viết mới nhất

- Khái niệm, mức độ tự trị và mức độ trừu tượng của AI Agent

- LangChain's OpenAI và ChatOpenAI, rốt cuộc nên gọi cái nào?

- Phần tiếp theo của DSPy: Tìm hiểu thêm về o1, Tính toán trong Thời gian Suy luận (Inference-time Compute) và Khả năng Lý luận (Reasoning) Trong phần trước, chúng ta đã khám phá những khía cạnh cơ bản của DSPy. Bây giờ, hãy cùng đi sâu hơn vào các yếu tố quan trọng như ngôn ngữ lập trình o1, hiệu suất tính toán trong thời gian thực hiện suy luận và cách hệ thống này có thể xử lý các bài toán phức tạp. Ngôn ngữ o1 được thiết kế để tối ưu hóa hiệu quả và độ chính xác. Nó không chỉ đơn thuần là một công cụ lập trình mà còn là nền tảng giúp người dùng tạo ra các mô hình thông minh với khả năng học hỏi và thích nghi nhanh chóng. Với o1, việc phát triển các ứng dụng AI trở nên dễ dàng hơn bao giờ hết, cho phép các nhà phát triển tập trung nhiều hơn vào logic và thuật toán thay vì lo lắng về các vấn đề kỹ thuật phức tạp. Tính toán trong thời gian suy luận (Inference-time Compute) đóng vai trò quan trọng trong việc xác định hiệu suất tổng thể của hệ thống. Đây là giai đoạn mà mô hình AI thực sự hoạt động - khi nó nhận đầu vào từ người dùng hoặc từ các nguồn khác và đưa ra kết quả dự đoán. Hiệu suất của bước này phụ thuộc rất nhiều vào cách mà mã nguồn được tối ưu hóa cũng như cấu trúc của mạng thần kinh mà mô hình sử dụng. Cuối cùng nhưng không kém phần quan trọng, khả năng lý luận (Reasoning) là điểm nhấn lớn nhất trong việc đánh giá trí tuệ nhân tạo. Một hệ thống AI mạnh mẽ không chỉ cần biết cách giải quyết các vấn đề cụ thể mà còn phải có khả năng phân tích tình huống, đưa ra phán đoán hợp lý và thậm chí tự điều chỉnh hành vi dựa trên hoàn cảnh. Điều này đòi hỏi một sự kết hợp giữa kiến thức chuyên sâu và kỹ năng xử lý dữ liệu linh hoạt. Vì vậy, khi nghiên cứu về DSPy, chúng ta không chỉ nhìn vào mặt kỹ thuật mà còn cần hiểu rõ tầm quan trọng của mỗi thành phần riêng lẻ trong việc xây dựng một hệ thống AI toàn diện và hiệu quả. Hãy tiếp tục theo dõi để tìm hiểu thêm về cách mọi thứ hoạt động bên trong!

- Nói chuyện về DSPy và kỹ thuật tự động hóa gợi ý (phần giữa)

- Nói chuyện về DSPy và kỹ thuật tự động hóa gợi ý (phần đầu)

- Giải thích một chút: Phân tích nguyên lý xác suất đằng sau LLM

- Bắt đầu từ Vương Tiểu Bảo: Giới hạn đạo đức và quan điểm thiện ác của người bình thường

- Xem xét lại thông tin từ GraphRAG

- Những điều thay đổi và không thay đổi trong sự thay đổi công nghệ: Làm thế nào để tạo ra token nhanh hơn?

- Thể trí thông minh doanh nghiệp, số hóa và phân công ngành nghề